既に他所でもいろいろとネタになっていますが、中古市場でも安価になってきた第11世代Core(虎湖・・・もとい、Tiger Lake)搭載ノートでローカルLLMが動作するかどうか確かみてみました。

検証した環境について

第11世代Core i5搭載ノートは今年になって大量に増えては減り、増えては(ryを繰り返しまくった結果、現在では4台(うち一台はCeleronなので言うまでも無く除外)所有していますが、ローカルLLMを動かすにはRAM容量が最低16GB以上無いと厳しいようなのでオンボードRAM 8GB構成のおさふぇぷろ7たすはここで脱落、RAM 16GBを搭載しているのはつでみいる5320ちゃんとシンクパヨウX1c Gen 9ちゃんの2台になりますが、モデルデータが一番コンパクトなものでも2.5GBとそれなりに大きいので、ストレージ容量に余裕があるシンクパヨウX1c Gen 9(Core i5-1135G7/RAM 16GB搭載)ちゃんにGUI環境でローカルLLMを簡単に動かすことができちまうんだ!る「LM Studio」を導入することにしました。

ちなみに虎湖世代のCPUにもAI処理用のアクセラレーターとして「Intel Gaussian & Neural Accelerator(GNA)2.0」が搭載されています。一応・・・

とりあえずOpenAIのgpt-OSSを・・・→だめでした

この記事を執筆している時点での最新バージョンとなるLM Studio Version 0.3.30では初回起動時にまずChat GPTでおなじみOpenAIがオープンソースで公開した「gpt-OSS-20b(11.28GB)」を最初にダウンロードするよう案内してくるので、ちょうど「あのOpenAIがオープンソースでモデルデータを公開!?!?!?!?」といろいろな場所で話題になっていたのでまずこちらから確かめてみることにしました。

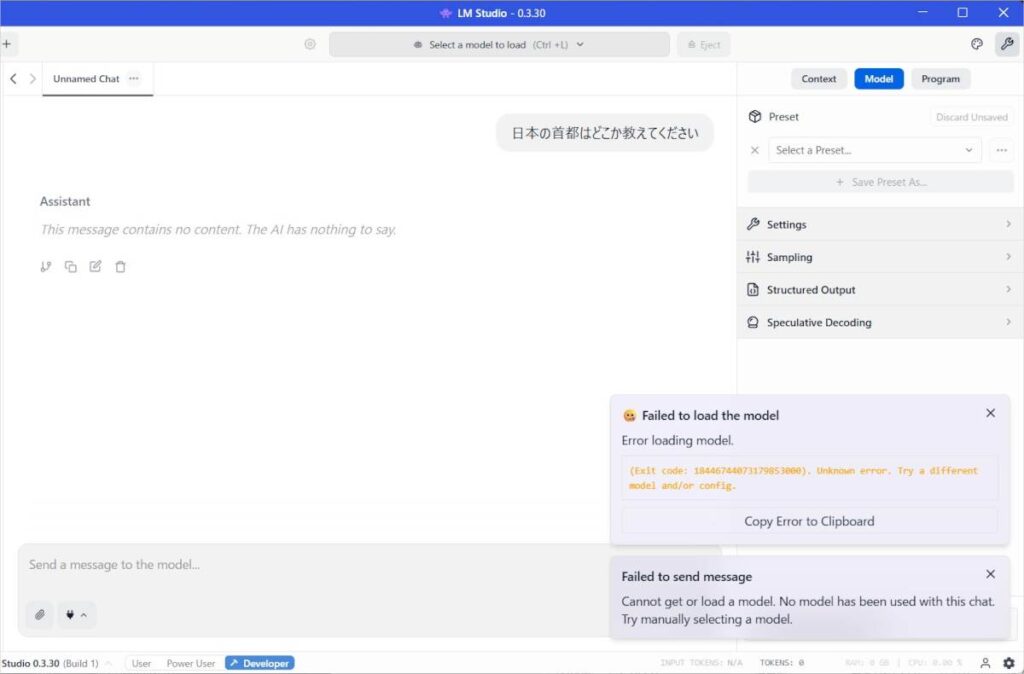

gpt-OSSには超ドハイエンドdGPUを搭載しているPCを所有しているユーザー向けの「gpt-OSS-120b」も用意されていますが、そもそもdGPUなんて物は搭載されていないX1c Gen 9ちゃんでは動作するわけがないので、比較的軽量で普通のノートPCやすまほんでも動くらしい軽量版のgpt-OSS-20bなら・・・と思ったのですが、「日本の首都はどこか教えてちょんまげ」というドシンプルな質問でもLM Studio本体が一瞬フリーズした後、「モデルデータのロードに失敗した」というエラーメッセージを吐いてしまいました。残念ながら第13世代以前のIntel Core搭載ノートだとgpt-OSSを動かすのはそもそも無理っぽいですね・・・(同世代のAMD Ryzenもおそらく同様)

他のモデルなら意外といける

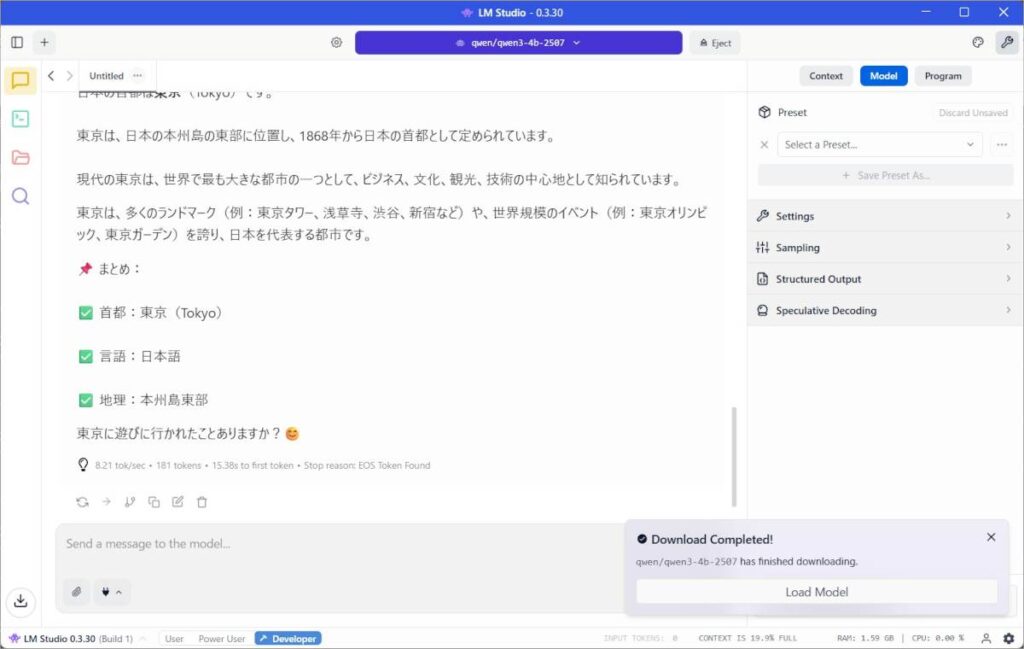

じゃもっと軽いモデルならいけるんじゃね?ということで、他のサイトさんでも動作検証されていた日本語対応のモデル、「Qwen-3 4B 2507(2.5GB)」を試してみることにしました。

まずジャブとして先ほどの「日本の首都はどこか教えてちょ(ry)」という質問を投げてみたところ、今度はChatGPTやGemini(CLIたんも含む)、コペェロットとほぼ同じ速度で割と正確な回答を出力してくれました。おぉ・・・

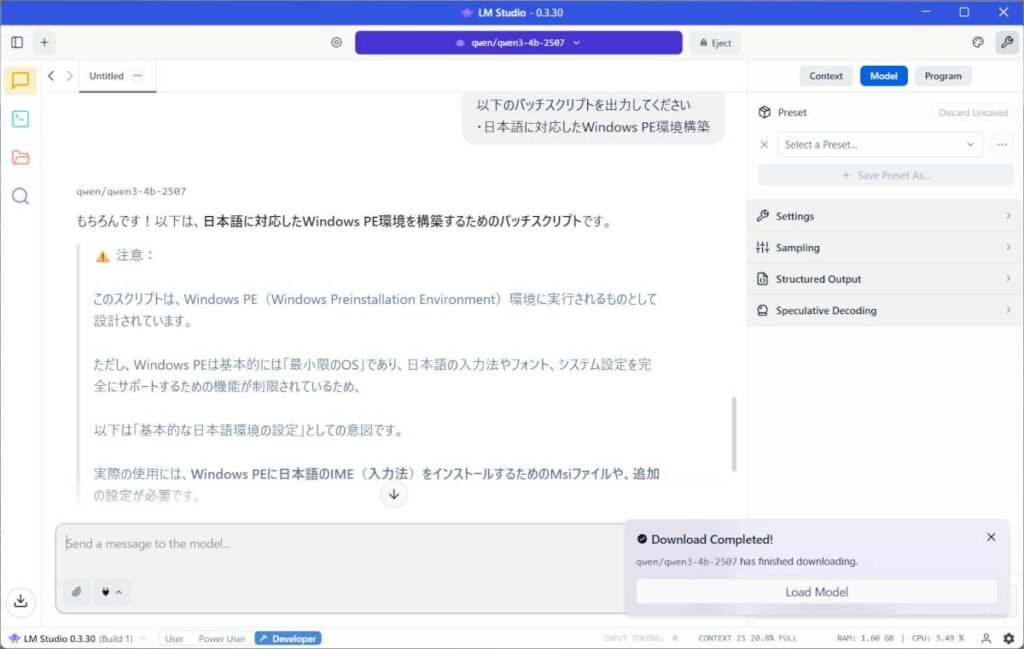

試しに今度は「日本語“表示”Windows PE環境を構築するバッチスクリプトを出力してちょ!」と頼んでみたところ、こちらもクラウドベースのAIアシスタントとほぼ変わらない時間で出力してくれたのですが・・・

- Windows PEは日本語入力をサポートしていない

- Windows ADK + PE Add-Onsに含まれているオプションコンポーネント、ランゲージパックの組み込みを行っていない(というかPEのイメージファイルを一時フォルダに展開する「CopyPE」コマンドすら実行してない)

- そもそもこれ通常のWindowsじゃないと動かねーじゃねーか!

と間違いまくったスクリプトを出力してくれたので、コードを書くお仕事で常用するのはいろいろ厳しそうです(ちなみに回答が英語のみになってしまいますが、FacebookでおなじみMetaが提供している超軽量モデル、Liama 3 8Bも同じような結果になりました)。

まとめ ― 常用できるかどうかは別にして軽量モデルなら第11世代Core i5搭載モバイルノートでもローカルLLMは動く

現状LM Studioではモデルデータの学習や微調整(ファインチューニング)はサポートされていないようなので、「Qwen-3 4B」や「Liama 3 8B」だとお仕事で使うのはいろいろと厳しいかなぁというのが正直な感想ですが・・・軽量なモデルであれば高性能なdGPUやNPUが搭載されていない、第11世代Core i5搭載モバイルノートでもローカルLLMを動かすことは可能でした。

簡単なお話相手としてならこれでも十分使えそうですし、ローカル環境で動作するので入力したデータを勝手に再利用される危険性もないので気になる方は試してみても良さそうです。ただちゃんと使うのであればやっぱりそれなりに性能が高いPCが必須かもしれませんね・・・(高性能なNeural Engineを搭載しているM1まくぶくえあえあだとまた結果が変わってくるかと思われるので、近いうちに確認してみたいと思います)。

コメントを残す